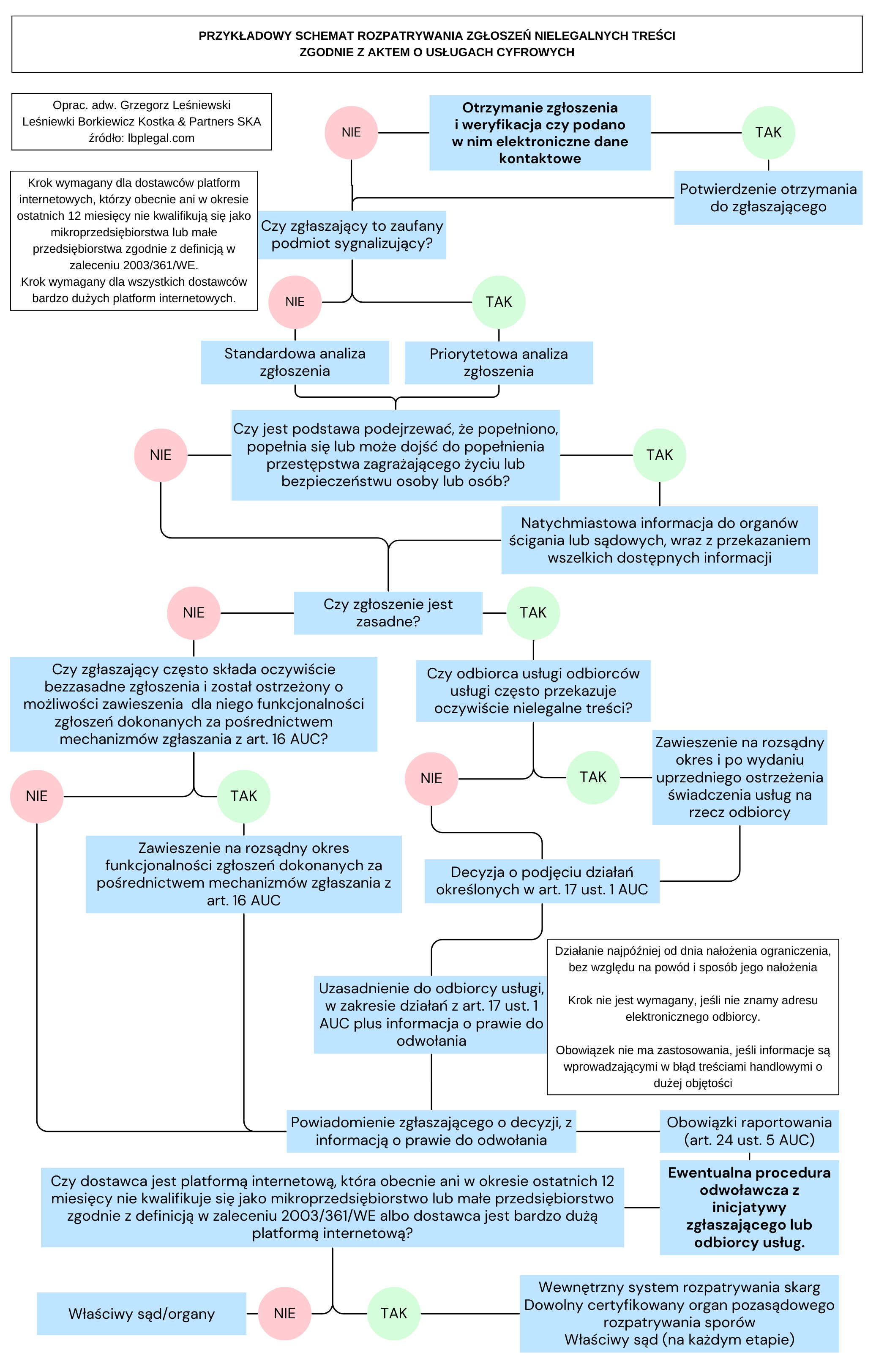

W lutym tego roku weszło w życie gro przepisów Aktu o Usługach Cyfrowych (AUC), europejskiego rozporządzenia zwanego potocznie nową konstytucją Internetu AUC jest próbą usystematyzowania i uporządkowania przepisów regulujących bezpieczeństwo funkcjonowania różnych grup użytkowników w sieci, np. młodocianych czy konsumentów. W starciu z gigantami internetowymi jak Google, Amazon czy Facebook, użytkownicy narażone na szereg nadużyć, typu wykorzystywanie podawanych przez siebie (zazwyczaj dobrowolnie) informacji bez swojej wiedzy, manipulowanie danymi, profilowanie, brak rzetelnych informacji o oferowanych usługach czy produktach. W publikacji przygotowanej przez prawników z kancelarii LBKP „Wdrożenie aktu o usługach cyfrowych”, do której zachęcam do zakupu na stronie wydawnictwa Beck https://www.ksiegarnia.beck.pl/22073-wdrozenie-aktu-o-uslugach-cyfrowych-w-e-commerce-mateusz-borkiewicz, którego miałam przyjemność współtworzyć, znalazły się praktyczne wskazówki dotyczące jego stosowania. Niniejszy artykuł skupia się na kwestiach związanych z ochroną konsumentów w sieci, szerzej omówionych w publikacji w rozdziale VIII mojego autorstwa.

Unia Europejska od wielu lat zajmuje się problemami konfliktu pomiędzy konsumentami a przedsiębiorcami. Z uwagi na coraz większą aktywność konsumentów w sieci, w szczególności za pośrednictwem internetowych platform cyfrowych, AUC jest odpowiedzią Unii na potrzebę wzmocnienia ochrony konsumentów przed zagrożeniami związanymi z e-handlem.

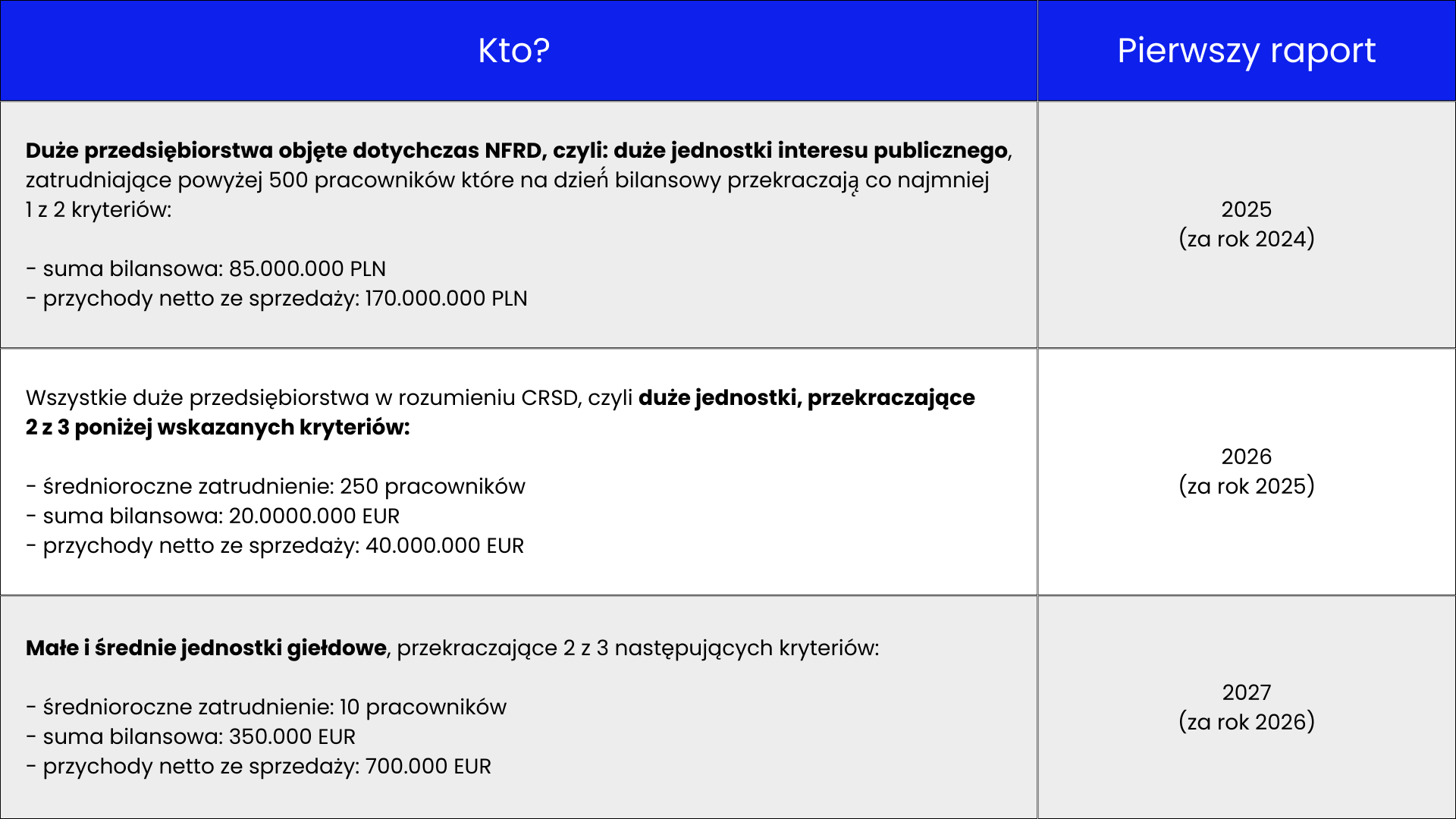

AUC w art. 29-32 (Sekcja 4 Rozdziału III) reguluje nowe obowiązki dla dostawców platform internetowych umożliwiających konsumentom – osobom fizycznym zawieranie z przedsiębiorcami umów zawieranych na odległość. Dotyczy to tylko tych platform, które kwalifikują się jako średnie lub duże przedsiębiorstwa, zgodnie z definicją w załączniku do zalecenia Komisji Europejskiej 2003/361/WE, lub wskazanych jako bardzo duże platformy internetowe (zgodnie z art. 33 AUC), np. Allegro, Amazon, Zalando.

W wielu przypadkach konsumenci nie zdają sobie sprawy, że zawierają umowę z drobnym przedsiębiorcą i nie mają po drugiej stronie internetowego giganta jako wypłacalnego partnera umownego. Platformy przyciągają konsumentów swoją nazwą, infrastrukturą, bogatą ofertą, a jednak umowa zawierana jest w rzeczywistości z nierzadko małym dostawcą działającym za pośrednictwem platformy e-handlu. Co prawda platformy mają wpływ na formę umowy (w szczególności poprzez swoje ogólne warunki), jednak nie ponoszą odpowiedzialności w przypadku wystąpienia problemów, pozostawiając konsumenta bez możliwości dochodzenia swoich roszczeń.

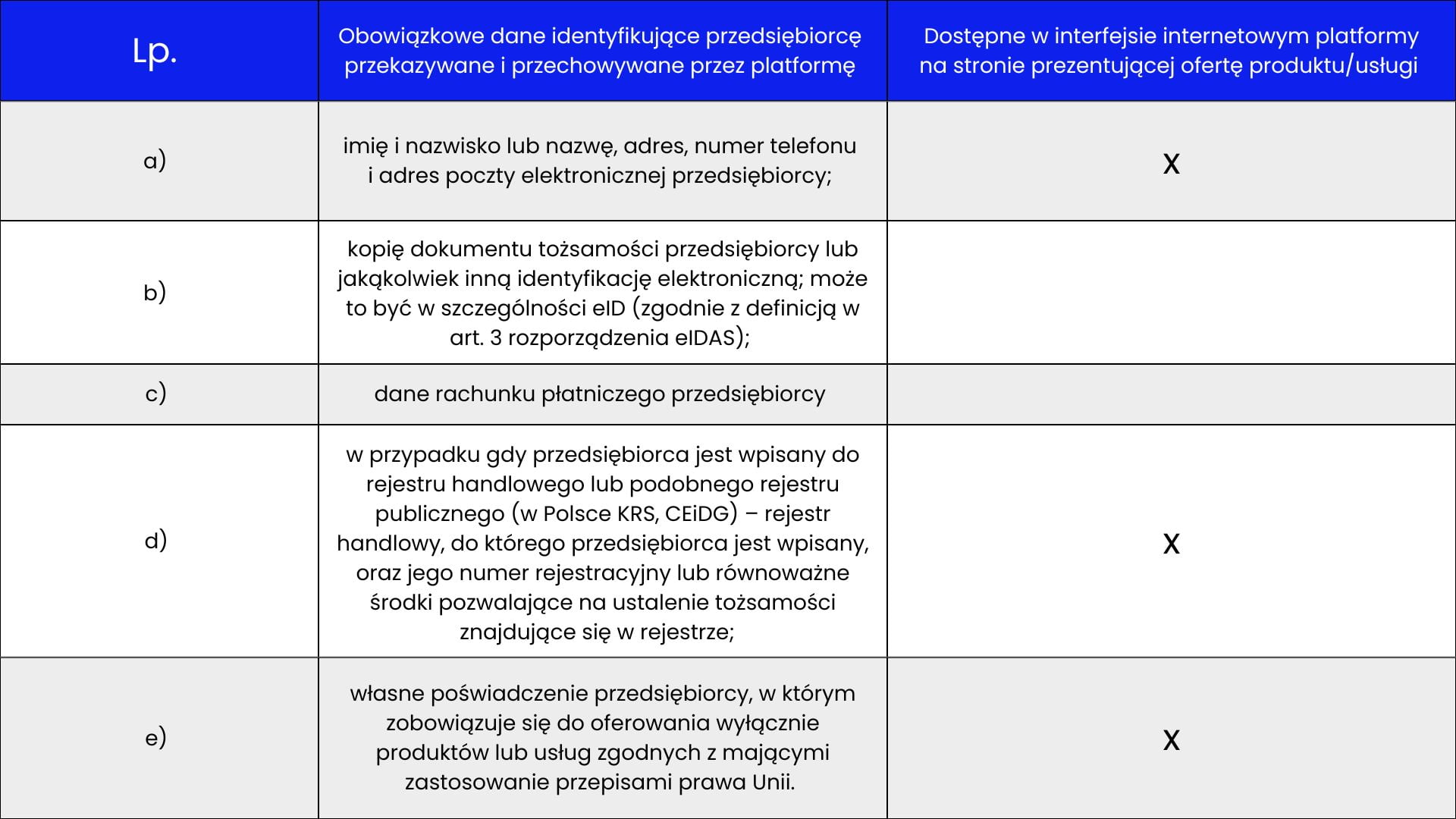

Pierwszą z nowości jest wprowadzenie dla platform e-handlu zasady „znaj swojego klienta” (art. 30 AUC), poprzez ułatwienie identyfikalności użytkowników platormy – przedsiębiorców. Celem jest stworzenie bezpiecznego środowiska internetowego dla konsumentów, konkurentów i posiadaczy praw własności intelektualne, i ograniczenie liczby fałszywych sklepów na platformach. Platformy powinny dopuścić do korzystania z ich usług tylko tych przedsiębiorców, którzy przekazali informacje i dane wymagane przez art. 30 AUC. Są to:

Źródło: opracowanie własne.

Część z tych informacji platforma e-handlu musi opublikować co najmniej w interfejsie internetowym, w miejscu gdzie przedstawione są informacje na temat produktu lub usługi. Platformy e-handlu powinny wszelkich starań do oceny, czy otrzymane od przedsiębiorcy informacje są prawdziwe, kompletne i aktualne, szczegóły dotyczące terminów dostarczenia i weryfikacji zawarte są w rozdziale VIII publikacji. Jeśli przedsiębiorca nie dostarczy danych lub wyjaśnień, platforma powinna zawiesić lub odmówić świadczenie usług pośrednictwa e-handlu wraz z uzasadnieniem. Na marginesie należy dodać, że przedsiębiorca, którego konto zostało zablokowane bądź nieutworzone, może bezpłatnie złożyć elektroniczną skargę oraz odwołać się od decyzji, o czym więcej w naszej publikacji.

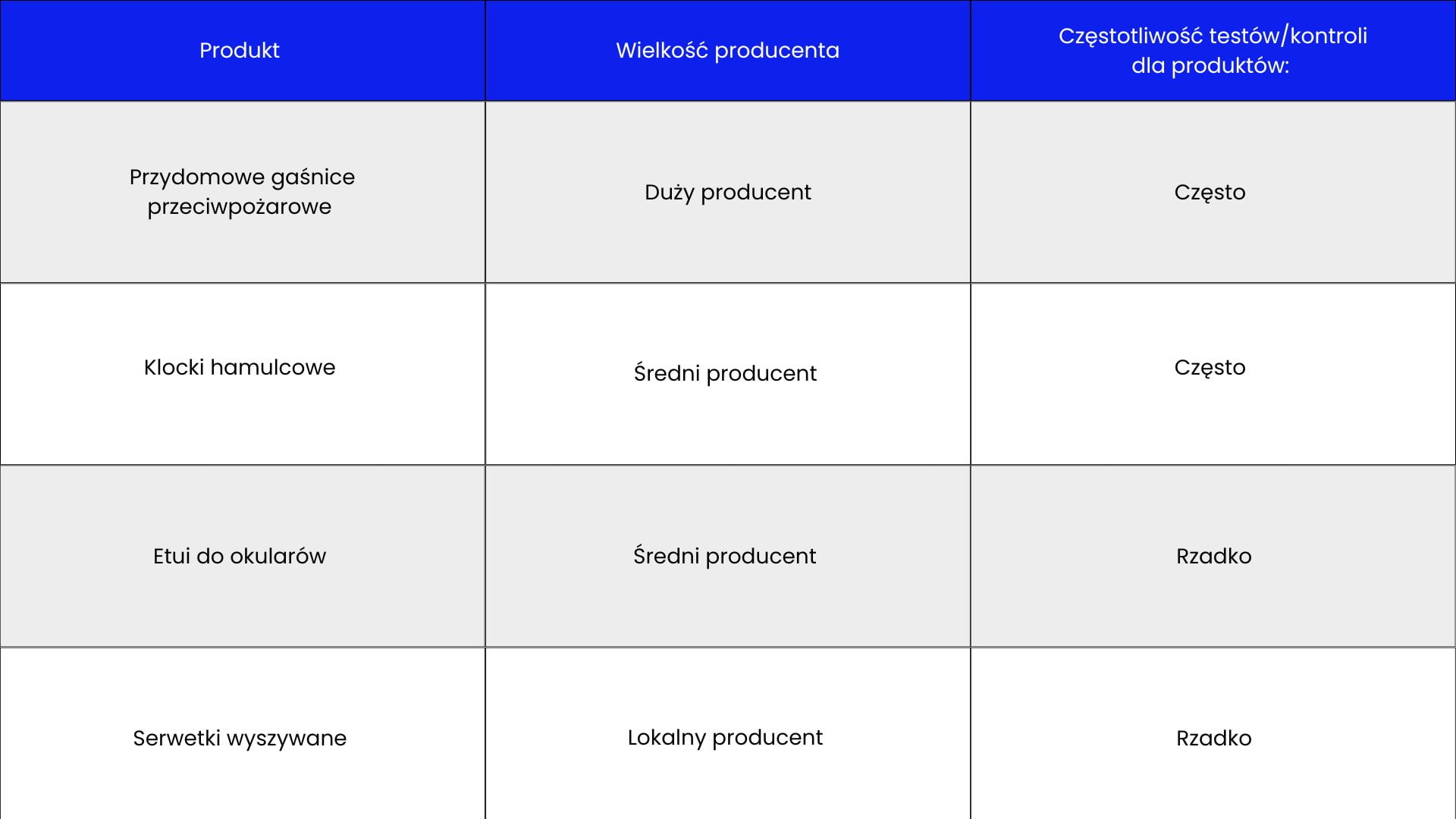

AUC wprowadziło wymogi dotyczące projektowania interfejsu (strony internetowej) dla platform e-handlu, aby były czytelniejsze i bezpieczniejsze dla potencjalnych klientów-konsumentów. Przedsiębiorcy oferujący swoje produkty powinni mieć możliwość podania w widocznym miejscu w odniesieniu do oferowanego produktu podanie nazwy, adresu, numeru telefonu i adresu poczty elektronicznej producenta lub właściwego podmiotu odpowiedzialnego za produkt, a także dokładnego opisu produktu wraz z logo, a w przypadkach produktów specjalistycznych, z rynków regulowanych również informacje dotyczące etykietowania i oznakowania zgodnie z obowiązującymi przepisami dotyczącymi bezpieczeństwa produktów i zgodności produktów. W tym przypadku platformy e-handlu nie są zobowiązane do weryfikacji prawdziwości tych informacji, ale powinny podjąć pewne działania kontrolne w stosunku do nich. Oferowane produktu i usługi powinny natomiast podlegać losowym kontrolom okresowo przeprowadzanym przez platformy. Przykładowe zestawienie częstotliwości kontroli oferowanych produktów lub usług przedstawione zostało poniżej w tabeli, przy czym szersze omówienie tych obowiązków zawarte jest w rozdziale VIII publikacji.

Tabela 5. Zestawienie częstotliwości kontroli oferowanych produktów lub usług

Źródło: opracowanie własne.

Mimo przełomowych zmian w e-commerce, konsumenci nadal stosunkowo często napotykają przeszkody w egzekwowaniu swoich praw jako ofiary oszustwa, czy w przypadku zakupu nielegalnych towarów. AUC idzie o kolejny krok dalej i zobowiązuje dostawców internetowych platform handlowych do informowania konsumentów, jeśli są świadomi niezgodności z prawem produktu lub usługi oferowanej lub już sprzedanej za pośrednictwem platformy e-handlu (art. 32 ust. 1 AUC). Dotyczy to wszystkich konsumentów, którzy nabyli taki nielegalny produkt lub usługę w ciągu 6 miesięcy od chwili dowiedzenia się dostawcy platformy e-commerce o nielegalnym charakterze takiego produktu lub usługi. Platforma e-handlu nie musi podawać uzasadnienia ani źródła przekazywanej o nielegalności produktu lub usługi, wystarczy że poweźmie wiedzę o takim fakcie, np. na podstawie monitorowania ofert, prawomocnego wyroku, zgłoszenia od użytkowników platformy lub policji. Przepisy AUC nie przewidziały szczególnej formy przekazania informacji nabywcy nielegalnego produktu, z pewnością wiadomość e-mail będzie właściwym środkiem zawiadomienia takich konsumentów. Krąg adresatów tej wiadomości jest ograniczony – dotyczy wyłącznie konsumentów, którzy nabyli nielegalny produkt w ciągu ostatnich 6 miesięcy, a więc bezpośrednio zainteresowanych, których faktycznie dotyczy ta sytuacja. Może się jednak zdarzyć, że dostawca internetowej platformy handlowej nie będzie posiadał danych kontaktowych wszystkich zainteresowanych konsumentów, którzy nabyli nielegalny produkt w ciągu ostatnich 6 miesięcy. Wystarczy, że jeden z konsumentów usunie w tym czasie swoje konto i dane kontaktowe. W takim przypadku platforma powinna podać do wiadomości publicznej w łatwo dostępny sposób informacje na swojej stronie internetowej.

Szersze omówienie przedstawionych powyżej zagadnień wraz z praktycznymi wskazówkami i przykładami zawarte jest w ww. publikacji w rozdziale VIII. Z pewnością dzięki przewidzianym w Sekcji 4 Rozdziału III obowiązkom dla dostawców internetowych platform handlowych AUC przyczyni się do wzmocnienia pozycji konsumentów na rynku, a także zwiększenia pewności i bezpieczeństwa obrotu w sieci.