Sztuczna inteligencja – czym jest (z prawnego punktu widzenia) i jak radzi sobie z nią świat

28 lutego 2024 / AI

„W szybko rozwijającej się dziedzinie technologii sztuczna inteligencja (AI) jest przełomową siłą, która nie tylko przekształciła branże, ale także zrodziła wiele pytań i wyzwań prawnych”.

Chat GPT poproszony o przedstawienie sztucznej inteligencji w kontekście wyzwań prawnych.

Czy istnieje definicja sztucznej inteligencji?

Obecnie nie ma prawnej definicji sztucznej inteligencji ani w Polsce, ani w Unii Europejskiej. Podobna sytuacja występuje również w innych głównych jurysdykcjach na świecie. Prawdopodobnie najbliższa definicji AI jest definicja “zautomatyzowanego podejmowania decyzji” zawarta w RODO, która może obejmować niektóre systemy AI.

RODO w art. 22 definiuje zautomatyzowane podejmowanie decyzji jako:

„… decyzja, która opiera się wyłącznie na zautomatyzowanym przetwarzaniu, w tym profilowaniu, i wywołuje wobec (…) osoby skutki prawne lub w podobny sposób istotnie na nią wpływa.”.

Definicja ta w swoim obecnym kształcie nie jest jednak wystarczająco konkretna, aby w wystarczający sposób “pokryć” pojęcie systemów sztucznej inteligencji jakie znamy obecnie.

Z prawnego punktu widzenia sztuczna inteligencja jest więc „tylko” technologią lub zestawem technologii i jest regulowana w taki sam sposób, jak każda inna technologia – poprzez wiele różnych przepisów mających zastosowanie do określonych kontekstów lub zastosowań. Może być wykorzystywana w dobrych celach lub w celu wyrządzenia szkody, jej użycie może być legalne lub nielegalne – wszystko zależy od sytuacji i kontekstu.

Dlaczego uregulowanie sztucznej inteligencji jest tak ważne?

Tempo rozwoju sztucznej inteligencji przyspiesza. A ponieważ sztuczna inteligencja jest „przełomową siłą”, różne kraje mają trudności z opisaniem tej technologii do celów legislacyjnych. W przeszłości ustawodawcy rzadko rozważali tworzenie nowych przepisów na poziomie międzynarodowym specjalnie dla pojedynczej technologii. Ostatnie lata dowiodły jednak, że coraz więcej przełomów technologicznych wymaga szybkiej reakcji prawnej – nie trzeba daleko szukać, wystarczy pomyśleć o przetwarzaniu w chmurze, blockchainie, a teraz o sztucznej inteligencji.

Przykładowo, różne części lub komponenty tej technologii mogą być własnością różnych osób lub firm (na przykład prawa autorskie do określonego kodu programu lub własność baz danych), ale idea sztucznej inteligencji jest publiczna. A ponieważ coraz więcej narzędzi i wiedzy na temat AI jest dostępnych dla wszystkich, teoretycznie każdy może korzystać z narzędzi AI lub tworzyć nowe narzędzia. Może się to wiązać z potencjalnymi nadużyciami, stąd regulacje prawne tej technologii są tak ważne.

Dlaczego jeszcze? Wszyscy zgadzają się, że sztuczna inteligencja ma potencjał, by zmienić krajobraz gospodarczy i społeczny na całym świecie. Oczywiście, to już się dzieje, a proces ten przyspiesza każdego dnia – co jest równie ekscytujące, co przerażające. Tempo rozwoju nowych technologii sprawia, że trudno jest przewidzieć rezultaty. Dlatego też kluczowe znaczenie ma posiadanie pewnych zasad prawnych, które zapewnią, że sztuczna inteligencja będzie wykorzystywana w sposób korzystny dla wszystkich. A ponieważ jest to „zjawisko globalne”, najlepiej byłoby, gdyby przynajmniej powszechnie uzgodniono, czym jest sztuczna inteligencja z prawnego punktu widzenia.

Najprawdopodobniej nie stanie się to jednak w skali globalnej. Niektóre kraje próbują zdefiniować sztuczną inteligencję ze względu na jej cel lub funkcje, inne ze względu na stosowane technologie, a niektóre łączą różne podejścia. Wiele kluczowych jurysdykcji stara się jednak uzgodnić definicję sztucznej inteligencji i znaleźć wspólne zasady. Jest to ważne, aby uniknąć praktycznych problemów, zwłaszcza dla dostawców globalnych rozwiązań AI, ponieważ wkrótce będą oni musieli zmierzyć się z licznymi kwestiami zgodności. Tylko co najmniej podstawowa interoperacyjność między jurysdykcjami pozwoli sztucznej inteligencji w pełni wykorzystać swój potencjał.

Podejście unijne

Różne kraje w Unii Europejskiej na wiele sposobów próbowały „podejść” do zagadnienia AI. Jeśli jednak szukamy szybkiej odpowiedzi na pytanie „jak najprawdopodobniej będzie wyglądać definicja sztucznej inteligencji w UE?”, większość odeśle nas do Aktu o Sztucznej Inteligencji, czyli AI Act, a właściwie jego projektu. Kraje członkowskie odraczają konkretne decyzji do czasu przyjęcia ostatecznej wersji AI Act, który w sposób kompleksowy ureguluje tę technologię na poziomie europejskim we wszystkich krajach członkowskich.

Aktualnie publicznie dostępna wersja AI Act zawiera następującą definicję systemu sztucznej inteligencji:

“An AI system is a machine-based system designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments.”

Źródło: https://www.linkedin.com/feed/update/urn:li:activity:7155091883872964608/

Co można tłumaczyć jako: “System sztucznej inteligencji jest systemem maszynowym zaprojektowanym do działania z różnymi poziomami autonomii, który może wykazywać zdolność adaptacji po wdrożeniu i który, dla wyraźnych lub dorozumianych celów lub ukrytych celów, wnioskuje na podstawie otrzymanych danych wejściowych, w jaki sposób generować dane wyjściowe, takie jak takie jak prognozy, treści, zalecenia lub decyzje, które mogą wpływać na fizyczne lub wirtualne środowiska.”

Jest to różnica w porównaniu do ostatniego tekstu AI Act z 2023 r., który system sztucznej inteligencji definiował jako “oprogramowanie opracowane przy użyciu co najmniej jednej spośród technik i podejść wymienionych w załączniku I, które może – dla danego zestawu celów określonych przez człowieka – generować wyniki, takie jak treści, przewidywania, zalecenia lub decyzje wpływające na środowiska, z którymi wchodzi w interakcję.”

Tym samym UE zbliżyła się w swojej definicji systemu sztucznej inteligencji do standardu OECD.

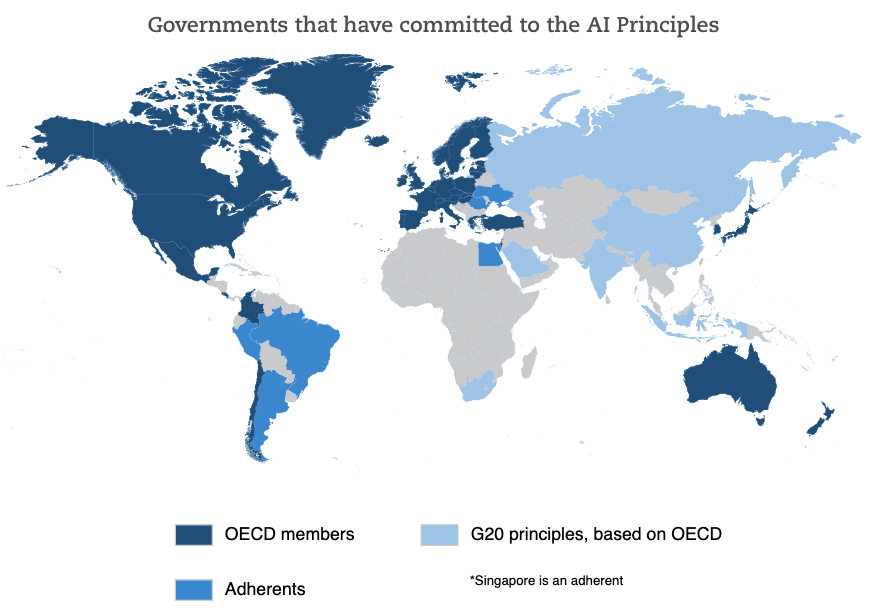

A czym jest ten standard? W listopadzie 2023 r. OECD (Organizacja Współpracy Gospodarczej i Rozwoju) zaktualizowała definicję AI zawartą w Zasadach AI OECD. Jest to pierwszy międzyrządowy standard dotyczący AI (został przyjęty w 2019 r.). Liczne władze na całym świecie zobowiązały się do stosowania tej definicji bezpośrednio lub z niewielkimi modyfikacjami. Do tej grupy należy również Unia Europejska.

Źródło: https://oralytics.com/2022/03/14/oced-framework-for-classifying-of-ai-systems/

Definicja Systemu AI OECD:

“An AI system is a machine-based system that , for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments. Different AI systems vary in their levels of autonomy and adaptiveness after deployment.”

(PL: “System sztucznej inteligencji to system oparty na maszynach, który dla celów jawnych lub ukrytych wnioskuje na podstawie otrzymanych danych wejściowych, w jaki sposób generować dane wyjściowe, takie jak prognozy, treści, zalecenia lub decyzje, które mogą wpływać na środowisko fizyczne lub wirtualne. Różne systemy sztucznej inteligencji różnią się poziomem autonomii i zdolności adaptacyjnych po wdrożeniu”).

Aktualny model systemu sztucznej inteligencji OECD

Oprócz wspomnianej definicji, w zaleceniach OECD wyznaczono pięć dodatkowych zasad opartych na wartościach dotyczących odpowiedzialnego zarządzania godną zaufania sztuczną inteligencją.

Zawierają one:

wzrost gospodarczy sprzyjający włączeniu społecznemu, zrównoważony rozwój i dobrobyt;

wartości i sprawiedliwość skoncentrowane na człowieku;

przejrzystość i “wyjaśnialność”;

solidność, bezpieczeństwo i ochrona;

odpowiedzialność.

W kontekście powyższych informacji kraje, które zobowiązały się przestrzegać zasad OECD dotyczących sztucznej inteligencji powinny odzwierciedlać wymienione aspekty (przynajmniej w teorii). W tym kontekście UE jest na dobrej drodze.

W jaki sposób sztuczna inteligencja jest interpretowana na poziomie globalnym?

Stany Zjednoczone

Oczywiście jedną z najbardziej aktywnych jurysdykcji, jeśli chodzi o sztuczną inteligencję, są Stany Zjednoczone.Zgodnie z informacjami zamieszczonymi na stronie Krajowej Konferencji Ustawodawców Stanowych w 2023 r. co najmniej 25 stanów, Portoryko i Dystrykt Kolumbii wprowadziły akty prawne dotyczące sztucznej inteligencji, z kolei 15 stanów i Portoryko podjęło rezolucje w tym obszarze. Poszczególne stany podjęły ponad 120 inicjatyw w związku z ogólnymi zagadnieniami związanymi z AI (przepisy dotyczące konkretnych technologii sztucznej inteligencji, takich jak rozpoznawanie twarzy czy samochody autonomiczne, są monitorowane osobno).

Podejście w Stanach Zjednoczonych jest więc różne. Jako ciekawostkę można podać, że w maju 2023 r. w Kalifornii został przedstawiony projekt aktu wzywającego rząd USA do nałożenia natychmiastowego moratorium na szkolenie systemów sztucznej inteligencji potężniejszych niż GPT-4 przez co najmniej sześć miesięcy, aby dać czas na opracowanie systemu zarządzania sztuczną inteligencją – jego status jest obecnie „oczekujący”, jednak nie wydaje się prawdopodobne, aby został przyjęty.

Jeśli chodzi o definicję sztucznej inteligencji, w Stanach Zjednoczonych nie ma jednolitej definicji prawnej. Jednak jeden z kluczowych aktów prawnych związanych z AI – National AI Initiative Act z 2020 r. – ustanowił National Artificial Intelligence Initiative Office i zdefiniował sztuczną inteligencję jako „system oparty na maszynach, który może, dla danego zestawu celów zdefiniowanych przez człowieka, dokonywać prognoz, zaleceń lub decyzji wpływających na rzeczywiste lub wirtualne środowiska”. Wyjaśnia dalej, że „systemy sztucznej inteligencji wykorzystują dane wejściowe oparte na maszynach i ludziach, aby – (A) postrzegać rzeczywiste i wirtualne środowiska; (B) abstrahować takie postrzeganie w modele poprzez analizę w sposób zautomatyzowany; oraz (C) wykorzystywać wnioskowanie modelu do formułowania opcji informacji lub działania”. Dokument ten koncentruje się jednak głównie na organizacji Biura Inicjatywy AI w celu wspierania rozwoju tej technologii w Stanach Zjednoczonych, a nie na regulowaniu samej sztucznej inteligencji.

Stany Zjednoczone zobowiązały się do przestrzegania zasad OECD dotyczących sztucznej inteligencji. Niemniej jednak istnieją również inne wskazówki dotyczące tego, czego należy się spodziewać po federalnych przepisach dotyczących sztucznej inteligencji. „The Blueprint for an AI Bill of Rights: Making Automated Systems Work for the American People” to miejsce, od którego warto zacząć. Został on opublikowany przez Biuro Polityki Naukowej i Technologicznej Białego Domu w październiku 2022 r. i zawiera listę 5 zasad, które mają „pomóc w zapewnieniu wskazówek w każdym przypadku, gdy zautomatyzowane systemy mogą znacząco wpływać na prawa, możliwości lub dostęp do krytycznych potrzeb społeczeństwa”. Zasady te obejmują:

1. Bezpieczne i skuteczne systemy

2. Ochrona przed dyskryminacją algorytmiczną

3. Prywatność danych

4. Powiadomienie i wyjaśnienie

5. Ludzkie alternatywy, rozważania i rozwiązania awaryjne

Definicja systemów sztucznej inteligencji objętych przez Blueprint obejmuje dwa elementy: (i) ma potencjał, aby znacząco wpłynąć na prawa, możliwości lub dostęp osób lub społeczności oraz (ii) jest „zautomatyzowanym systemem”. Zautomatyzowany system jest dalej definiowany jako „dowolny system, oprogramowanie lub proces, który wykorzystuje obliczenia jako całość lub część systemu do określania wyników, podejmowania lub wspomagania decyzji, informowania o wdrażaniu polityki, gromadzenia danych lub obserwacji lub w inny sposób interakcji z osobami i / lub społecznościami. Zautomatyzowane systemy obejmują między innymi systemy wywodzące się z uczenia maszynowego, statystyki lub innych technik przetwarzania danych lub sztucznej inteligencji i wykluczają pasywną infrastrukturę obliczeniową”. Gwoli wyjaśnienia, „pasywna infrastruktura obliczeniowa to dowolna technologia pośrednicząca, która nie wpływa ani nie określa wyniku decyzji, nie podejmuje ani nie pomaga w podejmowaniu decyzji, nie informuje o wdrażaniu polityki ani nie gromadzi danych lub obserwacji”, w tym np. hosting internetowy.

Jeśli chodzi o inne kluczowe jurysdykcje, żadna z poniższych nie ma żadnej powszechnie uznanej definicji prawnej, ale:

Chiny

Chiny określiły standardy na poziomie krajowym oraz lokalne adaptacje, które opierają się na niektórych definicjach związanych z funkcjonalnością systemów sztucznej inteligencji;

Hongkong

Stworzył wytyczne etycznego rozwoju i wykorzystania sztucznej inteligencji, które określają sztuczną inteligencję jako „rodzinę technologii, które obejmują wykorzystanie programów komputerowych i maszyn w celu naśladowania problemu- zdolności człowieka do rozwiązywania problemów i podejmowania decyzji”.

Japonia

Japonia określiła „Strategię AI 2022”. Została ona wydana przez Cabinet Office’s Integrated Innovation Strategy Promotion Council. Sugeruje ona, że „AI” odnosi się do systemu zdolnego do wykonywania funkcji uznawanych za inteligentne.

Singapur

Singapur z kolei podjął próby definiowania “sztucznej inteligencji” jako zestaw technologii, które mają na celu symulowanie cech ludzkich, takich jak wiedza, rozumowanie, rozwiązywanie problemów, percepcja, uczenie się i planowanie oraz, w zależności od modelu sztucznej inteligencji, dają wynik lub decyzję (taką jak prognoza, zalecenie i/lub klasyfikacja). Definicja ta została zamieszczona w Modelowych Ramach Zarządzania Sztuczną Inteligencją wydanych przez Infocomm Media Development Authority i Personal Data Protection Commission.

***

Na całym świecie trwają próby stworzenia prawnej definicji sztucznej inteligencji. Aktualnie jedną z najnowszych propozycji jest ta zaproponowana przez OECD. Uchwalenie AI Act w ostatecznej wersji z pewnością przyspieszy proces unifikacji podejścia do definicji AI na całym świecie. Otwarte pozostaje pytanie, czy niektóre kraje nie będą jednak chciały “wyróżnić” się mocno liberalnym podejściem do AI, aby to właśnie do siebie ściągać twórców tej technologii (bez szczególnego dbania o aspekty prawne i etyczne).

Autorzy: Mateusz Borkiewicz, Agata Jałowiecka, Grzegorz Leśniewski

Potrzebujesz pomocy w tym temacie?

Napisz do naszego eksperta

Artykuły z tej kategorii

Gigafabryka AI w Polsce – przełomowa inwestycja w sztuczną inteligencję

Gigafabryka AI w Polsce – przełomowa inwestycja w sztuczną inteligencjęCapCut a kwestie licencyjne i prawne – co musisz wiedzieć jako twórca

CapCut a kwestie licencyjne i prawne – co musisz wiedzieć jako twórcaOdpowiedzialność za szkody wyrządzone przez pojazdy autonomiczne – kto ponosi winę w świetle prawa?

Odpowiedzialność za szkody wyrządzone przez pojazdy autonomiczne – kto ponosi winę w świetle prawa?CUDA i dominacja NVIDIA – niewidzialna infrastruktura AI poza zakresem regulacji?

CUDA i dominacja NVIDIA – niewidzialna infrastruktura AI poza zakresem regulacji?Sójka AI – cyfrowy strażnik etyki i bezpieczeństwa

Sójka AI – cyfrowy strażnik etyki i bezpieczeństwa